阅读:0

听报道

译 | 集智翻译组

推荐语:

未来,我们将越来越多地被人工智能所包围。AI所面临的对象不仅仅是人类和自然,还包括人工智能本身。因此,理解AI彼此之间的互动就变得越来越重要。本次集智俱乐部公众号重磅推出了“泛在的AI”系列翻译文章,旨在介绍人们对由大量互动的AI构建的系统所做的最新研究成果和认识,这包括Science杂志上的重磅综述文章 “经济推理与人工智能”,它提出了“机器经济学”这一全新研究方向,指出主流经济学所构建的完美“经济人”这个物种可能更适用于AI而非人类。“人工智能在怎样对经济学理论产生改变?”是对这一综述文章的评论。“从大数据的衰落到算法经济的兴起”这篇文章则该述了算法经济将取代大数据分析成为全新动向这一商业趋势。——张江

摘要

在人工智能(Artificial Intelligence, AI)领域中,人们正在建立可以感知周围环境、为达到特定目的而采取理性行动的智能主体(agents)。换句话说,AI研究者们正在试图建立一个人造的“理性经济人”(homo economicus,即新古典主义经济学塑造的那个神化般完美的理性经济主体)。这篇文章综述了人们在创造“机器经济人”(machine economicus)这一新机器物种方面的研究进展,并对如何构建可在经济学情境下进行有效推理的人工智能所面临的挑战进行了深入探讨。假如AI实现了这一目标,或者至少足够接近了,即可以用理性主义的术语去思考AI了,那么我们就可以考量如何为多主体系统设计互动规则以表达那些由AI构成的经济系统。我们会发现,那些来源于经济学的规范化(Normative)设计理论更适合AI主体而不是人类主体。这是因为AI可以更好地符合那些理想化的假设,并能够遵循更新的规则和激励系统,而不是为不完美理性的人量身定制的规则来完成互动。

经济学是通过给人、公司和决策者的行为建立模型来研究经济活动,包括价值的创造,转化和实现,并试图抽象出规律。模型通常假定经济活动的参与者(人、公司、决策者)的行为是完全理性的,也就是说,参与者会基于可供选择范围,个人偏好和经验做出对自己最有益的决定。因为经济学使用数学工具来精确地量化经济活动,所以理性决策模型可以套用在经济学上。一些批评者认为经济学研究的对象“经济人”是一种虚构的物种,所以基于此构建的理论很难应用到真实人的行为上;而支持者承认理性模型虽然过于理想化,但是认为抽象模型并不是分析预测人的行为(集体或个人的行为)的。尽管理性模型不能完全准确地模拟人的行为,但是它可以从人们所做的决定中观察到个人偏好,也可以为政策的制定提供一些洞见。

人工智能研究同样涉及理性的概念,因为它为人们试图创建的计算人工物(computational artifacts)提供了理想化的参考。人工智能现代概念的核心是设计智能主体(感知环境并执行行动的实体(1))。评判人工智能设计的好坏是通过主体感知环境、采取行动后,比较行动结果与既定目标来判断的。感知、行动和目标的一致性是理性概念的本质。如果我们用主体在结果上的偏好程度来表示目标,并设定它在不确定性的决策框架下进行感知和行动,那么人工智能主体所面临的情形就刚好是标准经济学范式下的理性选择问题。因此人工智能设计者的任务是设计理性主体,或是在计算资源限制下最理性的主体(2-4),换句话说,人工智能用硅和信息作为材料合成出了“经济人”,更准确地说,是“机器经济人”。

因为人工智能和经济学都可以用理性模型来抽象,对两者进行跨学科研究便有了坚实的基础。我们要通过描述如何应用理性模型构建可以理性地与其他AI主体互动的AI主体等问题来开始这篇综述。假设AI已经成功地开发了一个完全理性的主体(可能比人理性很多),我们便可以研发由多个AI主体组成的系统,到时候这种多主体系统便可被当作AI经济系统,其中AI主体能与其他主体,公司和人进行交易。这个想法已经激发人们扩展经济学的规范设计理论,改进规则以应对多个AI主体的交互(5)。AI主体组成的系统可能呈现出新的经济现象,因此需要一个新的学科来理解它的运行方式和设计原理。比如说,人类认知的局限性限制了当前市场的设计,而AI主体组成的系统可能会出现更复杂的交互环境,更快的计算速度以及更大的计算量,这些问题都非常值得人们关注。

与此同时,人工智能的行为方式与人的行为方式的偏差也会带来新的挑战。在未来,我们将见到这样的景象:简易的人工智能机器人在亚马逊网站上给书籍定价,在opentable(餐厅预约的一款APP)给餐厅的座位定价(6)。虽然这些行为可以提高效率,但是由于AI机器人缺乏常识,以及设计者设计存在缺陷,一本书可能会被定价到2300万美元(7)。在未来,有关AI的复杂政策,更加严格的审查制度会对金融市场产生巨大影响;自动交易算法将会出现在美国股票市场70%以上的交易中(8)。考虑到这些情况,深入理解无处不在的AI主体在经济体系中的表现显得尤为重要。由于我们的推理已经从人转变为AI,而这些AI是为了帮助我们获取人类偏好、消除人类决策偏差,以及在复杂的环境中权衡成本和收益而设计的,所以我们必须思考改变我们赖以生存的经济机构和组织,以应对这种转变。

在“机器经济人”已然浮出水面之际,我们将关注经济学和AI交叉领域中的一些最重要的研究方向。我们将简要提及AI应用如何解决经济学上的一些常见的问题,比如匹配问题(9),市场清算问题(10)和智能电网的建模问题(11)。我们也会展示AI是如何在现实中应用经济学理论的:比如多主体学习过程的博弈方法(12),以及多主体系统的投票表决程序(13)。

1.构建“机器经济人”

构建理性的AI提出了一系列技术挑战,这些挑战在以往任何社会科学的理性主义建模中都没有提及。对经济学而言,主体态度(例如,信念和偏好)背后的理性是一种概念性的抽象。经济学家不必解释如何编码主体的“能力”和“偏好”,也不必说明主体的规划与行动算法,这些算法应该在以其认知基础为条件来执行的。

尽管许多AI架构确实直接以命题、目标等类似概念进行表征,但这并不意味着AI设计需要直接引入基于理性构造的数据结构。这样的表示可以简化AI系统的分析——例如,我们可以询问一个在具有稳健性的逻辑表达式上工作的推断算法是否能够保证所有结论都遵循前提。同样,如果AI的信念被编码为概率分布,那么我们可以询问它是否会根据贝叶斯理论和观察到的正确信息来更新其“信念”。然而,我们必须小心我们对主体态度的理解只是建立在其内部数据结构方面。决策中的缺陷或许意味着计算主体所持有的“信念”、追求的“目标”实质上与它们的直接编码存在着系统性差异。

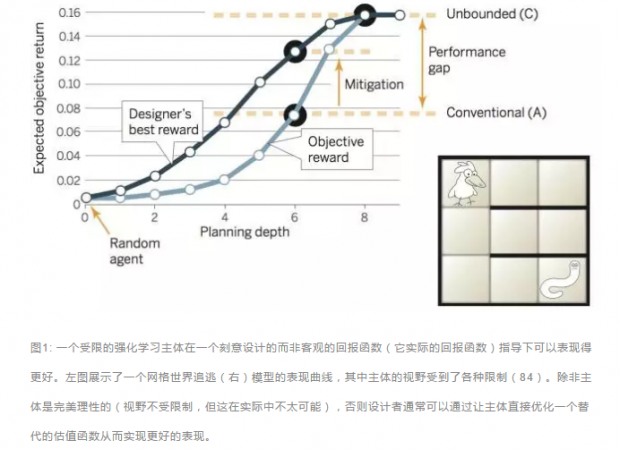

为了说明这种差异,让我们来看一个例子,即机器学习研究人员从动物学习中借鉴的“奖励成形”(reward shaping)概念(14)。在强化学习中,主体会根据回报(对主体所在状态和行动的瞬时估值)来得到一个策略函数(从感知序列到行动的映射)。一个设计者在明确了输入奖励的情况下,可以通过在学习过程中塑形奖励信号来更好地向设计者的最优目标收敛,从而更有效地训练主体。最优奖励框架(15)可以为我们提供一般的区分奖励规范和设计者目标的解决方案。如图1所示,对主体输入的最佳报酬通常与设计者的理想报酬不一致。这个视角有助于解释内在动机(如:好奇心)对一个灵活学习的主体所起到的作用。

虽然并不是所有AI研究人员都采用设计“机器经济人”的方式(特别是明确地使用这些术语)来解决问题,但在过去几十年的时间里,许多AI的进展都可以被理解为是让理性可操作化(operationalizing rationality)的进展。例如,30年前的AI在很大程度上避免使用概率推理,但现在却已经非常普遍,这是由于贝叶斯网络和相关的基于概率图的形式框架得到了大力发展。现在的概率建模语言已经可以支持一般关系的不确定性表达,这就超出了单纯用命题做表达的限制(16)。统计方法目前已经主导了机器学习和自然语言处理(17,18)领域。同样,对于偏好的处理(包括从AI主体设计者那里显示地获取偏好;紧凑地表达在复杂情形下的偏好,并让基于偏好的推理可执行)也已经被视为AI的标准配置。“规划”,即AI的一个子学科,研究在时间之上的行动,现在通常被形式化为一种在受限资源,存在多个目标,以及动作具有概率效应的情况下的优化问题。

AI会成功地开发出理想的理性主体吗?尽管我们努力创造“机器经济人”,绝对完美的理性在有限的计算资源下还是不可能实现的。更重要的问题是AI主体是否会与理想情况足够接近呢?现在的发展的确已经如此了,至少在有限的意义上是。每当我们对我们的机器进行拟人化描述时,我们基本上就在将它们视为理性的人,并根据它们的知识、目标和意图的模型来回应他们。这个问题的一个更精炼的版本是,形式化的理性理论将会非常好地适用于绝对语境下的AI主体行为,或将之与应用到人类身上的情况进行比较。尽管我们对理性理论能够多好地刻画人类行为还没有搞清楚,但具有讽刺意味的是,我们注意到,社会科学理论可能会更加忠实于非人类行为。

2.关于其他主体的推理

主体理论化的问题不仅是学术问题。如果我们可以构建一个AI主体,那么我们就可以构建许多个人工主体,而这些AI主体会像人一样对其他AI主体进行推理。对于为逼近“机器经济人”而设计的AI代理而言,它们应该彼此认为都是理性的,这至少可以作为一个基线假设。这些AI主体将采用一种博弈论的视角来看待世界,其中主体对彼此的行为做出理性的反应,这一点也应该被(递归地)假定是合理的。结果是,主体将希望它们的共同决策满足某种均衡,就像在标准的经济学思想中一样。

现在越来越多的AI研究将经济均衡模型应用到涉及多个主体的情境中,在这里AI主体(或AI与人类的组合)被合理地建模为近似理性的。该方法取得了显着的成功,至少在一些特定的环境下存在一些此前提的证据。正如单一主体理性不需要文献中的效用计算一样,均衡模型的适用性也不需要主体自身明确参与均衡推理。例如,关于博弈中的学习(learning in game)的文献(20)已经发现了大量有关简单的适应策略会收敛于策略平衡的条件。我们可以通过检查AI设计师为特定任务构建的主体来评估经济建模的有效性。例如,在一个对购物游戏(21)中相互竞争的AI交易主体的研究中,使用来自经济学的标准价格均衡模型(具体地,瓦尔拉斯均衡Walrasian equilibrium)的主体,在没有使用任何数据的情况下,就实现了与复杂的机器学习方法相当的预测精度。

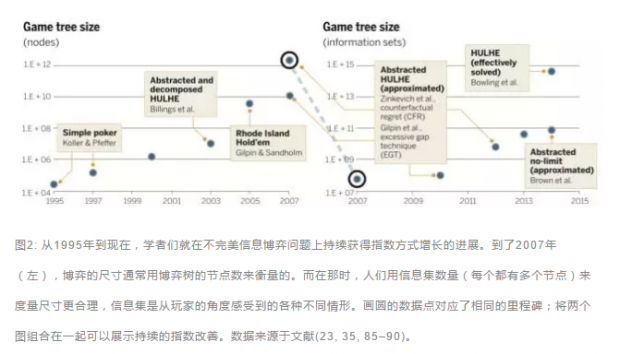

在本节的其余部分,我们描述了更多例子,其中,以博弈论算法为形式的经济建模为AI主体推理其他主体提供了有效的方法。第一个例子是计算机扑克。虽然扑克仅仅是一种人造的游戏,人们却投入了大量的时间和金钱来玩它以提生自己的技能。更重要的是扑克的不确定性和复杂性使它成为对AI技术的一个重要挑战。早期的研究旨在捕捉专业玩家的知识(22),但在过去的十年中,博弈理论算法占据了主导地位。 从技术上讲,扑克是一个不完美信息博弈,每个玩家都知道他人不知道的历史片段(发给他们的牌)。 随着时间的推移,通过转牌和投注,不确定性部分得到消解,玩家必须更新他们对自己的牌局的信念和对他人的信念。

2014年,计算机扑克取得了重大突破,这就是 “head up limit hold'em”(HULHE)——一个最流行的标准双玩家版本的扑克游戏变种的问题求解被攻克(23)。HULHE是人类已解决的不完全信息游戏中最大的一个(除去对称性后有超过1013个信息集),也是在日常游戏中,第一个被解决的不完全信息游戏。该解决方案是一系列研究者(参见图2)二十年努力的结果,从简化扑克游戏的精确解开始,到完整游戏(24)的抽象版本的大致解决方案。 计算整个游戏的近似纳什均衡需要大量计算和一种基于“遗憾匹配”(regret-matching,诞生于机器学习的一种方法)技术的平衡搜索新方法。结果是我们能够得到一种策略,使用这种策略可以让即使完美的对手也占不到任何便宜。

一般来说,针对完美对手的最佳策略可能不是理想的策略,而是对于易犯错误的情况更有针对性的策略。然而,尽管研究人员已经尝试了很多,但即使在对手处于均匀分布的情况下,我们仍然没有发现比博弈论解决方案更好的扑克算法。人们也已经证明,即使对那些远没有精确求解的扑克游戏变种而言(如赌注不受限制(25)或三个以上玩家(26),博弈论会比其他方法更成功。

AI中大部分基于博弈论的推理能够成功是因为它能解决现实世界的问题。近年来最突出的应用领域是我们接下来要讲的第二个例子,它基于Tambe等人开发的一系列系统(27)。在这些系统中,主体将通过求解一个博弈问题来决定如何布置安防设施(例如,机场中的安检点),在这些博弈中,袭击者被假设为一个理性的决策者并对防御者的决策制定规划。这种方法已经成功地部署在各种领域,包括机场与航线的安防工作以及海岸警卫队的巡逻。

正如其他的基于博弈论方法一样,这些系统给出的建议极其敏感地依赖于其他智能体(这里是攻击者)的偏好、信念、能力和理性水平。来自人工智能的代表性方法提供了更大的灵活性,这允许我们制定一些假设从而放松那些博弈理论家们所采纳的条件(28)。 行为博弈理论领域已经开发了详细的预测性模型,告诉我们人类是如何对博弈论所规定的理性产生系统性偏差的(29)。这样的预测模型可以被轻松地并入现有的博弈论推理算法中,正如在安全游戏(30)中对攻击者建模所展示的那样。一个有趣的开放性问题是是否能够很好地解释人类决策行为的模型(参见Wright和Leyton-Brown(31))也能有效捕获计算主体的有限理性。

3.设计多主体智能系统

在多主体级别中,设计者不能直接编程AI的行为,而是为AI之间的交互来定义规则和激励。这个想法是通过改变“游戏规则”(例如使某些行为和结果与奖励相关联)来改变智能体的行为以实现全局目标的。系统目标可以包括:促进总价值最大化的资源分配方案,协调行为以按时完成项目或汇集分散信息以形成对未来事件的准确预测。这种改变交互环境的能力是特别的,它能将这种设计与在给定世界中表现良好的AI设计问题区分开。

一个有趣的中间环节是把世界视为给定的,但利用可靠的主体——调解者——它可以与AI们互动并代表雇主执行行动(32)。引入调解者这种做法在新AI经济学中显得很自然。为了领教一下这是多么强大:让我们考虑在经典的囚徒困境博弈中引入协调机制(图3)。如果两个AI都授予中介人参与的权限(即代理权),那么这个主体就可以代表两个主体来执行合作。然而,如果只有一个AI授权中介代理,那么结果就可能代表该主体执行背叛。在均衡中,两个AI都授予代理,效果就是从(背叛,背叛)改变为(合作,合作),即同时增加了两个参与者的效用。

对于更一般的理性主体互动规则的设定,经济学里有一套成熟的数学理论:机制设计(mechanism design)(33)。机制设计的框架已经成功应用于例如匹配市场(34)和拍卖(35)的设计之中。机制设计是一种反向的博弈论问题,它可以通过规则诱导博弈和系统的质量评估到达均衡点。在标准模型中,我们会根据主体对结果的偏好来指定设计目标,但这些偏好是私人信息且主体都是利己的。一个机制是一个可信的实体,它能够从主体中接收关于偏好的声明(可能是不真实的)消息,并基于此来选择结果(例如,资源分配或行为规划)。制度设计的最大挑战是如何设计激励手段以促成主体真实地报告自己的偏好。

Varian(36)认为,相对于人类主体来说,机制设计理论实际上可能更适合人造主体,因为AI可以更好地遵守在这个框架中做出的对于理性的理想假设。例如,机制的一个期望属性是“激励相容性”,该属性保证了“真实地表达出自己所需”能够构成均衡。有时甚至可能使“诚实报告”成为一个占优策略(即不管其他人做什么这个策略都是最优的),这样就可实现 “防策略性”(strategy-proofness)的强大特征(37)。然而,似乎人们不能可靠地理解这种性能;来自医疗匹配市场和实验室实验的证据表明,一些参与者在防策略的匹配机制中试图错误地表达他们自己的偏好,即使这样做没有任何好处(38,39)。

相比之下,对于人工系统我们可能期望AI的行为是真实的,同时避免消耗大量关于他人行为推理的计算,因为这是没用的(5)。更一般地,AI系统的机制设计不需要简单,因为它们不需要让人类理解。相反,诸如偏好表示、偏好诱导和搜索算法这样的AI技术可以用于将机制设计的数学形式化框架转为具体的计算方法(40-42)。设计问题本身也可以有效地表达为一个计算问题,其中最优化方法和机器学习可以用于无法解析求解的设计问题 (43–46)。

AI经济的发展前景也激发了机制设计的新扩展。考虑到未来的不确定性以及由于局部环境的变化而导致的主体偏好的变化等因素(47-49),研究者们已经发展出了相容的多周期激励机制。另一个方向考虑了除偏好信息以外的一种新的私有输入信息(50,51)。例如,在团队建设的情境中,每个AI可能错误地报告关于其他AI的能力信息,以便使自己被选择进团队(52)。类似地,AI在寻求任务分配最大化时可能提供假的工作效能报告,以误导学习机制构建的自动任务分类器(53)。AI的系统也可对机制设计造成新的挑战。一个典型例子是假名投标,其中AI利用的是其可以管理多个身份的能力。例如,它可以通过将一个请求分成一组小请求,每个小请求安置在其控制下的不同身份来获得资源。 作为应对措施,研究人员已经开发出对这种新型攻击具有鲁棒性的机制(54)。

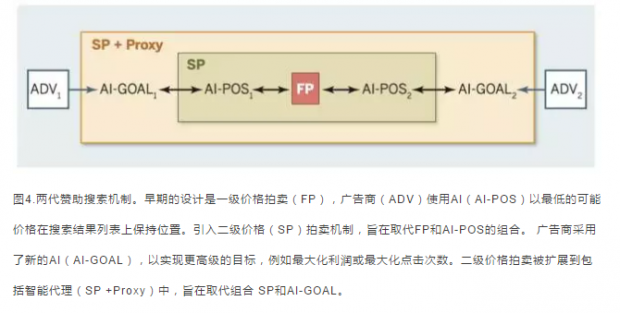

实践中存在着一些案例,其中机制设计在AI经济中起到了重要作用。在一定搜索请求条件下,搜索引擎通过拍卖的方式分配广告位。广告主为了让他们的广告出现在特定的查询中(例如“人身伤害律师”)而出价。系统会根据出价金额(以及其他因素,例如广告质量)来对各种广告进行排名,其中排名较高的广告会出现在搜索结果页更高的位置上。早期拍卖机制采用一级价格序贯拍卖(first order bidding)规则,系统会在广告收到点击时向广告客户收取其出价金额。认识到这一点,广告商就会使用AI来监控感兴趣的查询,从而在保持当前位置的条件下能够用尽可能低的价格竞价。这种做法导致了一连串的投标战争,从而导致了计算力的浪费和市场效率的低下(55)。为了克服这一点,搜索引擎引入了二级价格序贯拍卖(second order bidding)机制(37),其对广告商的收费是第二高的出价而不是竞标胜者自己的价格。这种方法(机制设计中的一个标准想法)就使得人们不必不断地监控价格以获得最佳价格定位,从而阻止了投标大战(56)。

近年来,搜索引擎竞价已经开始支持更丰富的,基于目标的出价语言。例如,广告客户可能要求在受预算约束的情况下对一组加权的查询主题来最大化点击(57,58)。搜索引擎可以提供代理主体,来代表广告客户出价以实现所述目标(59)。代理主体的的引入以及早期从一级价格拍卖到二级价格拍卖的转换本质上就是信息揭示原理(60-62)的计算应用,这是机制设计理论中的一个基本概念。简单地说,如果一个机制的规则和该机制的均衡策略被一个在功能上等同的新机制取代,那么这个新机制将是激励相容的。虽然在形式上说重新设计没有专门地考虑激励相容性,但二级价格拍卖和投标代理都可以看作为早期版本中的广告主的行为(通过AI)(见图4)。另外,广告平台还可以设计一种策略防范(strategy)机制[Vickrey-Clarke-Groves机制(37,63,64)]来决定广告空间分配:哪些广告被分配,哪些(非赞助的)内容陈列给用户(65)。图4.两代赞助搜索机制。早期的设计是一级价格拍卖(FP),广告商(ADV)使用AI(AI-POS)以最低的可能价格在搜索结果列表上保持位置。引入二级价格(SP)拍卖机制,旨在取代FP和AI-POS的组合。 广告商采用了新的AI(AI-GOAL),以实现更高级的目标,例如最大化利润或最大化点击次数。二级价格拍卖被扩展到包括智能代理(SP +Proxy)中,旨在取代组合 SP和AI-GOAL。

今天金融市场也显著地具备自动化主体和交互规则设计的特征。今天的市场是一个以电脑化交易为主导的市场,这些电子账户已经从定性上改变了市场行为。虽然很多细节还处于保密中,但据悉AI和机器学习技术被大量地应用在算法交易者设计与分析中(66)。算法交易使那些有速度优势的策略得以快速采用,同时也导致了昂贵的军备竞赛,以应对市场信息的最小延迟。人们将用周期性的拍卖,即每一秒清空所有订单一次来取代连续时间周期,从而就可以避免微小的速度提升优势。(67,68)。

我们举两个AI经济中多主体系统设计的例子。第一个示例系统能够整合多个AI持有的信息。我们可以通过预测市场来有目的地设计系统规则以实现这一目标(69)。 比较为人熟知的版本包括对美国总统竞选(例如,Betfair提供许多这样的市场)进行预测的市场。 预测市场的基本思想就是用证券合约交易来预测(例如,一个可能的合约是如果希拉里·克林顿当选,将支付1美元)。 当供给和需求平衡之后,最终价格就被解释为市场预测(例如,价格$ 0.60反映了支付事件的概率为0.6)。

让我们考虑一个大量的相互关联的随机变量池,例如,“BA214航班延迟超过1小时”,“波士顿的暴风雪”,“除冰机坏了”,“BA215航班延迟超过 1小时”和“伦敦的安全警报”。在组合预测市场(70)中,合同“除冰机坏了”的大赌注将影响 “BA215航班延迟超过 1小时”和其他所有相关联的事件。 这里的挑战是可能的事件数量会随随机变量的数量呈指数增长。 除此之外,良好的市场设计还应能够让AI对所有事件下注(例如,“除冰机故障以及从波士顿延迟超过1小时的所有后续航班”)。良好的设计还应该使激励相一致—— 例如,使其效用最大化来实现对当前信息的立即交易,直到市场价格能反映代理的信念。最近在扩大组合市场方面取得的进展可以将定价赌注与众所周知的统计推理和凸优化问题(71,72)相关联。相关研究的进展还包括假设AI可以通过机器学习以及直接在信息信号而不是信念中进行交易(73-75)。

第二个例子是AI经济体内的主体的可信赖度信息管理的例子。对交易伙伴的信任对于任何运作良好的经济体系都至关重要。以前标准的做法是将参与者与他的声誉相关联,这可以权衡当前受损的声誉和未来丢失的机会,从而调整激励手段。除了这个道德风险的问题以外(即,当完成经济交易时,主体将进行合作),信誉系统还可以解决逆向选择的问题(即,高质量主体选择首先进入市场)(76,77)。

在AI经济中的一个特殊挑战是身份的流动性和主体可以被轻易替换的问题。这引起了诸如“粉饰攻击的幽灵(specter of whitewashing attacks)”这样的问题,其中AI在以不同的身份重新进入系统,这样它就可以在重新进入系统之前任意地挥霍它的声誉。在没有强制性的不能更改的身份制度的情况下,这种流动性身份耗费了大量的社会成本,这种成本就使得我们必须将惩罚也均摊到所有新参与者身上,并让它们在不可信的假设中建立声誉(78)。

我们还应该考虑到,“机器经济人”对于那些将反馈信息分享给其他AI系统分享反馈意见方面具有战略意义。例如,在eBay的原始报价系统中,买家通常不愿对失业卖家留下负面反馈,因为卖家可能进行报复。作为回应,eBay引入了一种从买方到卖方的单向反馈机制使得从卖方追溯到特定买方非常困难。这种变化导致了更大量的负反馈(79)。

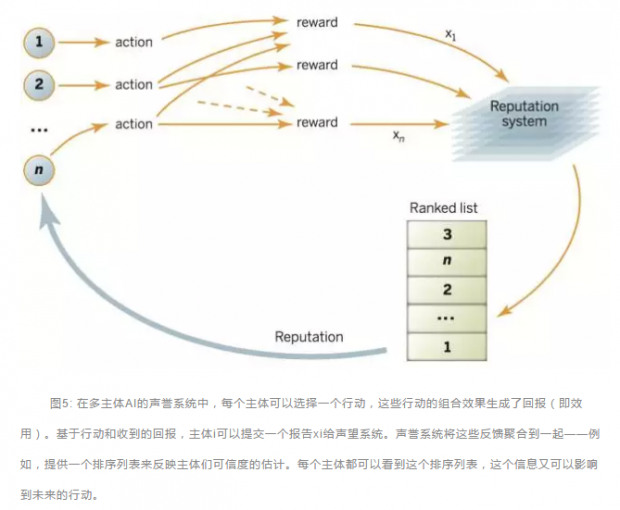

AI经济也为全新的声誉机制(见图5)中进行反馈信息收藏、反馈来源追踪提供了很好的机会。AI研究人员正在设计声誉系统,使激励与制作真实报告一致,同时也可证明它满足一些公理性质,例如对称性:从报告的角度来说两个同等位置的主体应该具有相同的信任得分(80,81)。另一个例子是会计系统的设计,它可以诱导出关于其他AI在资源贡献或工作表现上的真实报告,并使系统的设计能够减少搭便车现象并促进对经济体系的公平贡献(82)。然而,可完全通过计算基础设施(如信誉机制)的开发,而无需求助于法律系统,来设计有效的多主体AI系统仍然是一个有趣的开放性问题。

结论

不论人们对于AI是否或何时能够超过人类表现的观点有不同的看法,AI的快速发展正在激发对于其相关研究的极大的乐观情绪和投入。AI已经或者预计很快将在诸多窄领域内超越人类,比如下象棋、控制大型喷气式客机巡航、在电子商务平台上做商品推荐和为成千上万的商品做定价、判断病人是否可能再次住院,以及从信息量巨大的财经新闻中提取重要讯息。

当然,在这个发展过程中仍然存在很多根本性的挑战。这些挑战包括如何设计论证和推理方法,来有效平衡计算量带来的收益和运行中从延时到真实世界执行过程中所产生的可能成本;以及如何设计在信赖域中通过增强信号来学习和归纳的AI系统。尽管经济交易层面的决策问题都相对容易处理,但我们相信飞速发展的AI很有可能将在重要经济应用领域做出巨大贡献。这又进一步促进了对理性的经济推理方法,进而以实现“机器经济人”的愿景为目标的研究。

我们不应认为AI研究者们已经在单智能体或多智能体AI经济学展望上达成了全体共识。对于有些研究者来说,考虑多智能体的经济学模型仍然被视为一种干扰噪音。毕竟集中化的视角可以使系统更好的专注于目标达成,而不用担心对系统中每个个体成员的激励。还有一些研究者的工作针对的是受设计者控制的单智能体组成的多智能体系统,在这种系统中设计者可以用任意需要的方式编程单智能体。就像集中化解决方案一样,这种所谓的“协同”多智能体系统的设计可以不用考虑每个智能体的个体利益,尽管该系统经常遇到分解或沟通方面的问题。不过,协同或是自利的分歧其实是在对设计者权力的假设上的不同,而不是技术层面上的争论。我们所采纳的观点认为大量的AI系统将会像人类经济系统那样,由有着无数不同设计者、拥有者和操纵者的智能体所组成,每一个智能体的目标可能都各不相同。最后,有的研究者单纯从物理和计算限制的角度出发,反对基于“AI还远没有达到完全理性”假设的经济学方法。因为针对AI计算行为的更为直接的模型,从自动机理论的角度,是可以发展的更为精确的。对于AI理性抽象的分析效用终究是经验主义上的问题,有待在AI发展进程中解决。

在采取了经济学方法的研究者中间,也存在着一些具体技术层面上的争议- 比如均衡推理的作用。即便智能体可以被看作理性的,仍有研究者质疑是否应该使它们达到均衡结构,尤其是在多种均衡共存的情况下。正如Shoham (83)所论证的,博弈论缺乏具体推理层面的务实及广为接受的方法说明。对此有一种积极的观点认为,AI研究者在将经济推理操作化的时候恰恰正在发展出这一套欠缺的实用机制。

还有一些人可能会认为,机制设计,即便其对象是AI系统,也过于理想化了,还有比如其对均衡行为设计的坚持,对交互规则可以从无到有进行设计的预设,以及其对AI系统运行的人文和法律背景的细节忽略等大量问题。对此,积极的观点认为AI系统恰好提供了我们建立新交互规则所需要的空白,因为这些规则将可以通过互联网和电脑服务器上程序的运行来实现。而这些运行规则的实现既是公共政策问题,也是科学工程问题。

我们相信,随着AI 的发展,经济理性将在单智能体和多智能体设计领域发挥重要作用,同时我们认为伴随着AI经济的持续涌现,需要发展出一种新的科学来理解如何设计这些系统。这些AI系统无疑将在经济和更广阔的社会领域产生重大影响,对这些影响的效果和程度的研究将是未来数年来AI和经济研究领域的重要主题。

参考文献

1. S. Russell, P. Norvig, Artificial Intelligence: A Modern Approach (Prentice Hall, ed. 3, 2009).

2. J. Doyle, Comput. Intell. 8, 376–409 (1992).

3. E. J. Horvitz, Computation and action under bounded resources, thesis, Stanford University (1990).

4. S. Russell, in Fundamental Issues of Artificial Intelligence, V. C. Muller, Ed. (Springer, Berlin, 2015).

5. J. S. Rosenschein, G. Zlotkin, Rules of Encounter: Designing Conventions for Automated Negotiation among Computers(MIT Press, Cambridge, 1994).

6. M. McCue, Can’t secure a reservation to a hot restaurant? Try using an algorithm, Fortune, 3 September 2014; http://

7. J. D. Sutter, CNN, 25 April 2011; TECH/web/04/25/amazon.price.algorithm.

8. T. Hendershott, C. M. Jones, A. J. Menkveld, J. Finance 66, 1–33 (2011).

9. D. J. Abraham, A. Blum, T. Sandholm, 8th ACM Conference on Electronic Commerce (2007), pp. 295–304.

10. A. Frechette, N. Newman, K. Leyton-Brown, 24th International Joint Conference on Artificial Intelligence (2015).

11. S. D. Ramchurn, P. Vytelingum, A. Rogers, N. R. Jennings, Commun. ACM 55, 86–97 (2012).

12. R. I. Brafman, M. Tennenholtz, Artif. Intell. 159, 27–47 (2004).

13. A. X. Jiang et al., Adv. Neural Inf. Process. Syst. 27, 2573–2581 (2014).

14. A. Y. Ng, D. Harada, S. J. Russell, 16th International Conference on Machine Learning (1999), pp. 278–287.

15. S. Singh, R. L. Lewis, A. G. Barto, J. Sorg, IEEE Transactions on Autonomous Mental Development 2, 70–82 (2010).

16. L. Getoor, B. Taskar, Eds., Introduction to Statistical Relational Learning (MIT Press, Cambridge, 2007).

17. M. I. Jordan, T. M. Mitchell, Science 349, 255–260 (2015).

18. J. Hirschberg, C. D. Manning, Science 349, 261–266 (2015).

19. Y. Shoham, K. Leyton-Brown, Multiagent Systems: Algorithmic, Game-Theoretic and Logical Foundations (Cambridge Univ. Press, Cambridge, 2009).

20. D. Fudenberg, D. K. Levine, The Theory of Learning in Games (MIT Press, Cambridge, 1998).

21. M. P. Wellman, D. M. Reeves, K. M. Lochner, Y. Vorobeychik, J. Artif. Intell. Res. 21, 19–36 (2004).

22. D. Billings, A. Davidson, J. Schaeffer, D. Szafron, Artif. Intell. 134, 201–240 (2002).

23. M. Bowling, N. Burch, M. Johanson, O. Tammelin, Science 347, 145–149 (2015).

24. T. Sandholm, AI Mag. 31, 13–32 (2010).

25. N. Brown, S. Ganzfried, T. Sandholm, 14th International Conference on Autonomous Agents and Multi-Agent Systems (2015), pp. 7–15.

26. R. Gibson, Regret minimization in games and the development of champion multiplayer computer poker-playing agents, Ph.D. thesis, University of Alberta (2014).

27. M. Tambe, Security and Game Theory: Algorithms, Deployed Systems, Lessons Learned (Cambridge Univ. Press, Cambridge, 2011).

28. Y. Gal, A. Pfeffer, J. Artif. Intell. Res. 33, 109–147 (2008). 29. C. F. Camerer, Behavioral Game Theory: Experiments in Strategic Interaction (Princeton Univ. Press, Princeton, 2003).

30. R. Yang, C. Kiekintveld, F. Ordóñez, M. Tambe, R. John, Artif. Intell. 195, 440–469 (2013).

31. J. R. Wright, K. Leyton-Brown, Evaluating, understanding, and improving behavioral game theory models for predicting human behavior in unrepeated normal-form games, CoRR abs/ 1306.0918 (2013);

32. D. Monderer, M. Tennenholtz, Artif. Intell. 173, 180–195 (2009). 33. L. Hurwicz, in Mathematical Methods in the Social Sciences, K. J. Arrow, S. Karlin, P. Suppes, Eds. (Stanford University Press, Stanford 1960), Ch. 3, pp. 27–46.

34. T. Sönmez, U. Ünver, in Handbook of Social Economics, A. Bisin, J. Benhabib, M. Jackson, Eds. (North-Holland, 2011), vol. 1A, pp. 781–852.

35. P. Milgrom, Putting Auction Theory to Work (Cambridge Univ. Press, Cambridge, 2004).

36. H. R. Varian, 1st USENIX Workshop on Electronic Commerce (1995), pp. 13–21.

37. W. Vickrey, J. Finance 16, 8–37 (1961).

38. Y. Chen, T. Sönmez, J. Econ. Theory 127, 202–231 (2006). 39. F. Echenique, A. J. Wilson, L. Yariv, Clearinghouses for two-sided matching: An experimental study, Working Papers 487, University of Pittsburgh, Department of Economics (2013).

40. N. Nisan, in Combinatorial Auctions, P. Cramton, Y. Shoham, R. Steinberg, Eds. (MIT Press, Cambridge, 2006), chap. 9.

41. T. Sandholm, C. Boutilier, in Combinatorial Auctions, P. Cramton, Y. Shoham, R. Steinberg, Eds. (MIT Press, Cambridge, 2006), chap. 10.

42. T. Sandholm, Artif. Intell. 135, 1–54 (2002).

43. V. Conitzer, T. Sandholm, 18th Conference on Uncertainty in Artificial Intelligence (2002), pp. 103–110.

44. S. Alaei, H. Fu, N. Haghpanah, J. D. Hartline, A. Malekian, 13th ACM Conference on Electronic Commerce (2012), p. 17. 45. Y. Cai, C. Daskalakis, S. M. Weinberg, 54th Annual IEEE Symposium on Foundations of Computer Science (2013), pp. 618–627.

46. P. Duetting et al., ACM Transactions on Economics and Computation 3, 5:1-5:41 (2015).

47. D. C. Parkes, S. Singh, Adv. Neural Inf. Process. Syst. 16, 791–798 (2003).

48. R. Cavallo, D. C. Parkes, S. Singh, 22nd Conference on Uncertainty in Artificial Intelligence (Cambridge, MA, 2006), pp. 55–62.

49. D. C. Parkes, in Algorithmic Game Theory, N. Nisan, T. Roughgarden, E. Tardos, V. Vazirani, Eds. (Cambridge Univ. Press, 2007), chap. 16, pp. 411–439.

50. Y. Shoham, M. Tennenholtz, Theor. Comput. Sci. 343, 97–113 (2005).

51. J. Y. Halpern, V. Teague, 36th Annual ACM Symposium on Theory of Computing (2004), pp. 623–632.

52. N. Alon, F. Fischer, A. Procaccia, M. Tennenholtz, 13th Conference on Theoretical Aspects of Rationality and Knowledge (2011), pp. 101–110.

53. O. Dekel, F. A. Fischer, A. D. Procaccia, J. Comput. Syst. Sci. 76, 759–777 (2010).

54. M. Yokoo, Y. Sakurai, S. Matsubara, Games Econ. Behav. 46, 174–188 (2004).

55. B. Edelman, M. Ostrovsky, Decis. Support Syst. 43, 192–198 (2007).

56. B. Edelman, M. Ostrovsky, M. Schwarz, Am. Econ. Rev. 97, 242–259 (2007).

57. C. Borgs et al., 16th International Conference on World-Wide Web (2007), pp. 531–540.

58. J. Feldman, S. Muthukrishnan, M. Pál, C. Stein, 8th ACM Conference on Electronic Commerce (2007), pp. 40–49.

59. A. Z. Broder, E. Gabrilovich, V. Josifovski, G. Mavromatis, A. J. Smola, 4th International Conference on Web Search and Web Data Mining (2011), pp. 515–524.

60. L. Hurwicz, in Decision and Organization, R. Radner, C. B. McGuire, Eds. (North-Holland, Amsterdam, 1972), Ch. 14, pp. 297–336.

61. A. Gibbard, Econometrica 41, 587–602 (1973).

62. R. Myerson, Econometrica 47, 61–73 (1979).

63. E. Clarke, Public Choice 11, 17–33 (1971).

64. T. Groves, Econometrica 41, 617–631 (1973).

65. H. R. Varian, C. Harris, Am. Econ. Rev. 104, 442–445 (2014).

66. M. Kearns, Y. Nevmyvaka, in High Frequency Trading: New Realities for Traders, Markets and Regulators, D. Easley, M. Lopez de Prado, M. O’Hara, Eds. (Risk Books, London, 2013), Ch. 5, pp. 91–124.

67. E. Budish, P. Cramton, J. Shim, The high-frequency trading arms race: Frequent batch auctions as a market design response, Tech. Rep. 14-03, Booth School of Business, University of Chicago (2015).

68. E. Wah, M. P. Wellman, 14th ACM Conference on Electronic Commerce (2013), pp. 855–872.

69. R. Forsythe, F. Nelson, G. R. Neumann, J. Wright, in Contemporary Laboratory Experiments in Political Economy, T. R. Palfrey, Ed. (University of Michigan Press, Ann Arbor, 1991), pp. 69–111.

70. R. D. Hanson, Inf. Syst. Front. 5, 107–119 (2003).

71. J. Abernethy, Y. Chen, J. W. Vaughan, ACM Transactions on Economics and Computation 1, 12:1-12:39 (2013).

72. M. Dudík, S. Lahaie, D. M. Pennock, D. Rothschild, 14th ACM Conference on Electronic Commerce (2013), pp. 341–358.

73. J. Abernethy, R. Frongillo, Adv. Neural Inf. Process. Syst. 24, 2600–2608 (2011).

74. J. Witkowski, D. C. Parkes, 13th ACM Conference on Electronic Commerce (2012), pp. 964–981.

75. J. Hu, A. J. Storkey, 31st International Conference on Machine Learning (2014), pp. 1773– 1781.

76. P. Resnick, K. Kuwabara, R. Zeckhauser, E. J. Friedman, Commun. ACM 43, 45–48 (2000).

77. C. Dellarocas, Manage. Sci. 49, 1407–1424 (2003).

78. E. J. Friedman, P. Resnick, J. Econ. Manage. Strategy 10, 173–199 (2001).

79. G. Bolton, B. Greiner, A. Ockenfels, Manage. Sci. 59, 265–285 (2013).

80. A. Cheng, E. Friedman, ACM SIGCOMM Workshop on Economics of Peer-to-Peer Systems (2005), pp. 128–132. 81. A. Altman, M. Tennenholtz, J. Artif. Intell. Res. 31, 473–495 (2008).

82. S. Seuken, J. Tang, D. C. Parkes, 24th AAAI Conference on Artificial Intelligence (2010), pp. 860–866.

83. Y. Shoham, Commun. ACM 51, 74–79 (2008).

84. J. Sorg, S. Singh, R. Lewis, 27th International Conference on Machine Learning (2010), pp. 1007–1014.

85. D. Koller, A. Pfeffer, Artif. Intell. 94, 167–215 (1997). 86. D. Billings et al., 18th International Joint Conference on Artificial Intelligence (2003), pp. 661–668.

87. A. Gilpin, T. Sandholm, 7th ACM Conference on Electronic Commerce (2006), pp. 160–169.

88. M. Zinkevich, M. Johanson, M. Bowling, C. Piccione, Adv. Neural Inf. Process. Syst. 20, 905–912 (2007).

89. A. Gilpin, S. Hoda, J. Peña, T. Sandholm, 3rd International Workshop on Internet and Network Economics (2007), pp. 57–69.

90. S. Hoda, A. Gilpin, J. Peña, T. Sandholm, Math. Oper. Res. 35, 494–512 (2010).

人工智能在怎样对经济学理论产生改变?

从大数据的衰落到算法经济的兴起

特别鸣谢

本文译者:@刘清晴 神经 深圳 ,@Yanting Fulfill the Promise Wan ,@hehe ,@Cicely-大气科学-成都 ,@腰果-金融-武汉 ,@点点-物理, @Shu

审校:张江 。

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号