阅读:0

听报道

导语

这是假新闻的黄金时代,人们只会被谣言牵着走,拯救真相,可能要靠AI了。

编译:集智翻译组

来源:

原题:People are bad at spotting fake news. Can computer programs do better?

浏览一个新闻报道有时觉得像在玩儿两真一假游戏。

有一些假话很容易识破。就像第一夫人梅兰妮娅·川普(Melania Trump)想让一个驱魔人来净化奥巴马时期白宫的恶魔,又或者一名俄亥俄州的校长因在学生大会上拉屎而被逮捕的报道。在其他一些案例中,瞎编的内容和事实结合得有点太完美了。CNN(新闻电台)真的被美国联邦通信委员会突袭了?警察真的在一个阿拉巴马的沃尔玛里发现了一个毒品实验室?假的,还是假的。但是任何一个浏览大量故事的人都很容易被骗。

我们生活在假信息的黄金时代。在推特上,假信息比真相传播的更快更远(SN:3/31/18,p.14)。据BuzzFeed新闻分析,在2016年总统大选的预备阶段,相比于最真实的新闻,广为流传的假新闻会得到更多的facebook的分享,反应和评论。

链接:

链接:

在互联网出现之前,一位来自加州大学圣克鲁斯分校(the University of California, Santa Cruz)的计算机科学家卢卡·德阿尔法罗(Luca de Alfaro)说:“你没法让一个人坐在阁楼里构想出很多的阴谋论。但伴随着当今的社交媒体,兜售谎话实在是太容易了--无论这些谎言来自像Disinfomedia这样拥有好几个假新闻网站的组织,还是来自在马其顿一群通过写大选期间假新闻迅速捞钱的青少年。

大多数互联网使用者可能并不是故意传播假新闻的。信息过量和上网者有限的集中注意时间对真实信息的检查并没有帮助。确认偏见也同样如此。

一位在意大利威尼斯大学(Ca’ Foscari University of Venice)研究信息是怎么在社交网络上扩散的的计算机科学家法比安娜·佐洛(Fabiana Zollo)说:“当你处理未经筛选的信息时,人们可能会选择符合他们自己想法的事情,尽管信息是假的。“

无论分享者有意与否,分享假信息会产生严重后果。假新闻不仅仅会威胁大选的完整性,消磨公众对真实新闻的信任,还会威胁生命。在WhatsApp(美国版微信,一种智能手机通讯系统)上传播的假的传闻煽动印度私刑导致了数人死亡。

为了帮助挑选真假新闻,程序员正在建立判断网上故事的真实性的自动化系统。程序可能会考虑一篇文章的某些特征或者文章在社交媒体上获得的反响。识别出某些危险信号的电脑会提醒人工检查员,他们会做最终决定。

印第安纳大学布卢明顿分校(Indiana University Bloomington)的计算机科学家乔凡尼·卢卡·钱帕格利亚(Giovanni Luca Ciampaglia)说:“‘自动测谎的工具’仍在起步阶段。”研究人员正在探索有哪些因素可以很可靠地确定假新闻。

不幸的是,他们没有商定好的真假故事组用来测试他们的策略。一些程序员依靠建立好的媒体或者国家新闻机构来确认故事是真是假,其他程序员则根据社交媒体上被举报的假新闻列表。因此这方面的研究可以说是谁都可以参加。

但是全世界的研究小组都在快速推进研究,因为互联网每天信息量很大,就像消防水带喷水,依靠人工检查信息真实性就好比用Brita滤水壶(很小)来过滤消防水带的水,很困难。“这有点让人头脑麻木“,最年久最大的网上事实检测网站Snopes的一位科学作家亚历克斯·卡斯普拉克(Alex Kasprak)说道,“就是网上有太多的假新闻了。”

读者参照

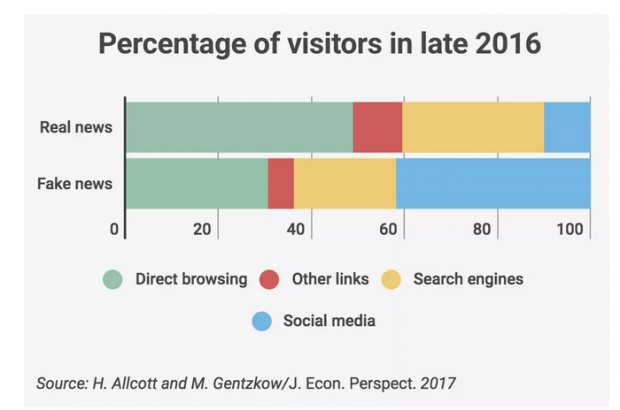

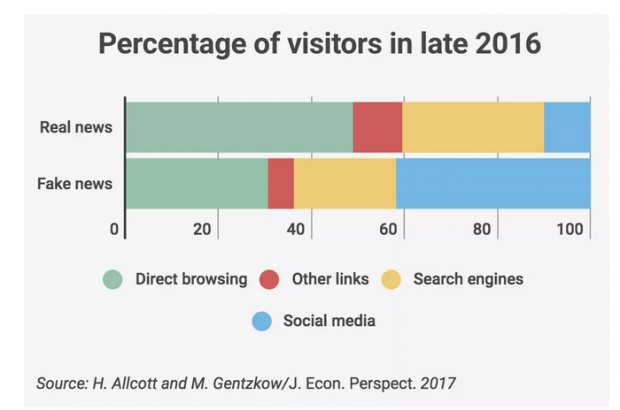

访问真实新闻网站的人基本上都是直接访问这些网站或者通过搜索引擎。假新闻网站通过社交媒体上的链接吸引更多浏览量的分享。

如何判别新闻真假:主旨和形式

说到直接检查新闻内容时,有两种方法来判断故事真假:作者在说什么和作者是如何叙述的。

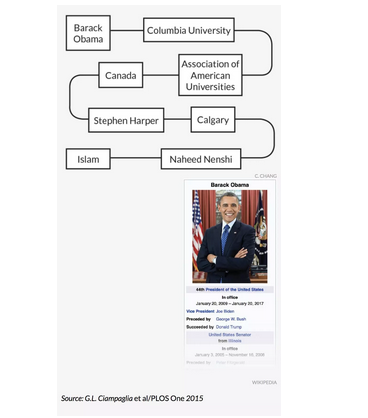

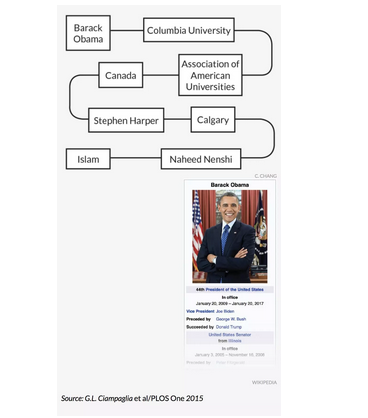

钱帕利亚(Ciampaglia)和同事们用一个程序自动完成了这个令人厌烦的任务,这个程序检查一个句子的主体和客体有多么关联。为了做到这一点,这个程序采用了从每页维基百科右侧的信息栏里的事实构建的庞大的名词网络--尽管已经有类似的网络从其他知识库被构建成,例如研究数据库。

在钱帕利亚小组的名词网络中,如果一个名词出现在另一个的信息栏中,两个名词就是有关联的。一份声明的主体和客体之间在这个网络中分离度越小,连接主体和客体的中间词越具体,这个电脑程序越可能把这个声明标记为真实的。

以“巴拉克·奥巴马(Barack Obama)是穆斯林“的虚假声称为例,在这个名词网络中,“奥巴马(Obama)”和“伊斯兰(Islam)”之间有7个分离度,包括连接很多其他名词的非常普遍的名词,如”加拿大(Canada)“。2015年发表在 PLOS ONE 的一篇论文显示,这个自动检查事实的程序可以根据“奥巴马”和“伊斯兰”之间悠长曲折的路径,判断出“奥巴马不可能是穆斯林”。

大致路径

自动事实检查程序通过研究从维基百科信息创建的名次网络中单词“奥巴马”和“伊斯兰”的分离度来判断“奥巴马是穆斯林”这一声称。这两个单词之间过于模糊的联系表明了这份声明是假的。

但是根据这种主客观分离度来估计语句的真实性是有局限的。举个例子,这个系统认为前总统乔治·布什(George W. Bush)可能娶了劳拉·布什(Laura Bush)。这很好。它还认为乔治·布什可能娶了芭芭拉·布什(Barbara Bush),他的妈妈。这就糟糕了。钱帕利亚和同事们一直致力于让他们的程序对这个网络中名词之间的关系有更细致的看法。

确认一篇文章中每一句话并不是判断故事是否真实的唯一办法。写作风格也可能是另一个突破口。在纽约特洛伊伦斯勒理工学院(Rensselaer Polytechnic Institute in Troy, N.Y.)的计算机科学家班杰明·何尼(Benjamin Horne)和西贝尔·阿达利(Sibel Adali)从媒体中分析了75篇被Business Insider认为非常真实的文章和75篇从误导骗人的网站黑名单中选出的假故事。相比于真实的新闻,假的文章趋于更短,重复使用更多的副词。假的故事包含更少的引用,技术型语句和名词。

根据这些结果,研究人员创建了一个电脑程序,这个程序用假新闻4个最有力的独特因素——名词的数量,引用的数量,多余度和单词总量,来判断文章真实性。这个在去年蒙特利尔网络和社交媒体国际会议上展示的程序以71%的成功率把假新闻和真新闻分开(一个程序随机把真假消息分类大概有50%正确率)。何尼和阿达利正在寻找假新闻的新特性来提高正确率。

链接:

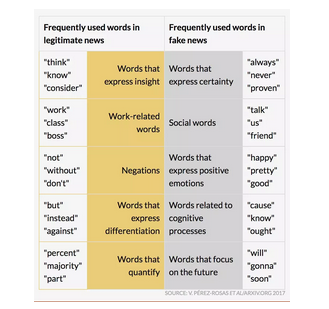

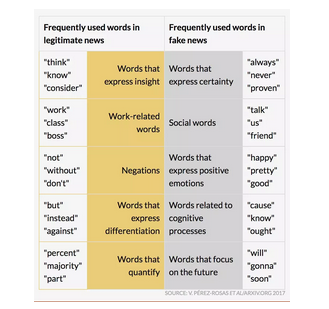

一位在密西根大学安娜堡校区的计算机科学家维罗妮卡·佩雷斯-罗萨(Verónica Pérez-Rosas)和他的同僚们对比了240篇真实和240篇瞎编的文章。就像Horne何尼和Adali阿达利,佩雷斯-罗萨的团队在假文章中发现了比真文章中更多的副词。在这个2017年8月23日报告于的分析中的假新闻同样趋于用了更多的积极语言,表现更多的确定性。

链接:

真话假话

一个数百篇文章的研究反映出真实和虚假新闻的格式上的区别。真实的故事包含更多表达分化的语言,然而虚假的故事表现出更多的确定性。

电脑不需要人类告诉它们假文章的哪方面露馅了。加州大学河滨分校(the University of California, Riverside)的计算机科学家,工程师瓦格里斯·帕帕利亚基斯(Vagelis Papalexakis)和同僚们建立了一个根据故事的相似性,将一些文章分类成组的假新闻探测器。研究人员并没有提供如何评估相似性的具体说明。一旦这个程序按相似度将文章分组,研究人员会标记5%的文章为真实的或虚假的。

通过这个信息,这个描述于4月24日在上的算法,会为剩下没标记的文章预测标记。帕帕利亚基斯的团队用twitter上分享的将近32000个真实和32000个虚假的文章,测试了这个系统。根据一小核(5%)的真相,这个程序能正确为其他69%的故事预测标记。

链接:

成人监督

大概70%的正确率并不足够准确,可以让我们完全信任新闻审查程序。但是当一个用户在浏览器上打开一个可疑的文章时,假新闻检测器可以提供一个谨慎处理的提醒,类似于当你即将访问一个没有安全证书的网站时出现的提醒。

首先,社交媒体平台可以用假信息看门狗巡查新闻推送中有问题的文章,然后再传给人工检查员。如今,当选择对哪些文章进行真实性检测时,Facebook看重用户的反馈——像那些认为不相信的评论或者认为文章是虚假的报告。公司随后会将这些文章发送给,PolitiFact或者Snopes这样的专业公司进行鉴定。但是Facebook也对用其他的迹象来更有效地搜寻假信息持开放态度,Facebook发言人劳伦·斯文森(Lauren Svensson)说到。

无论电脑找假新闻多厉害,它们仍然不能完全取代人工检查员,Horne 说到。判断一个故事真假与否需要更加细微的观察,这不是一台电脑能做得到的。

“假信息的界定是模糊的“,一位帝国理工学院的计算机科学家,经济学家胡里奥·阿马多·迪亚兹·洛佩兹(Julio Amador Diaz Lopez)说到。一些特殊情况,包括从上下文取出的事实,宣传和几乎不可能核实的声明,比如宗教信仰,电脑很难识别的了。

Snopes的科学作家卡斯普拉克(Kasprak)设想未来的事实检测将像计算机辅助录音。第一步,自动化系统敲定出一个录音的草稿。但是人类仍然需要检查草稿中被忽略的细节,比如拼写和语法错误,又或者使程序出错的单词。同样的,电脑能编辑出可疑文章的名单来供人类检查,卡斯普拉克强调人类仍然有着哪个标记为真实的最终决定权。

关注观众

即使算法在判断假文章上变得越来越精明,但不能保证虚假新闻创作者不会提高他们的造假手法以逃避检测。如果电脑程序被设计成怀疑过于积极或者表达了很多的准确性的文章,那么写假新闻的作者就会相应地改善他们的写作方式。

“假新闻,就像病毒一样,可以自己进化升级。”这是北京航空航天大学的网络科学李大庆的观点,他是研究推特上假新闻的专家。好在,我们评判网络新闻报道的真假,不光根据内容本身。

墙头草

大多数讨论这下面两个灾难的虚假谣言的Twitter用户发推也只是单单地传播了这些谣言。只有小部分发推寻求确认或者对故事表示怀疑。

一位在北京中国科学院计算技术研究所的计算机科学家曹娟发现在中国版twitter——新浪微博上,关于某条新闻的特定微博是判断一篇特定文章真假与否的有力根据。曹的团队建立了一个系统,把讨论某一特定的新闻事件的微博聚集起来,然后把这些帖子分成两组:一组表现为支持故事的,一组为反对的。这个系统考虑好几个因素来衡量这些帖子的可信度。

例如,如果故事是集中发生在距离一名用户很近的本地事件,那么这名用户的帖子则比离得远的用户的帖子更可信。如果一个用户潜水了很长时间并开始发关于一个事件的帖子,那么这种反常行为降低了这个用户的可信度。通过衡量支持和怀疑帖子的社会思潮,程序会判断一个特定的故事是否有可能是假的。

曹的团队在73个真实的和73个虚假的事件上测试了这一技术,这些事件都被像中国新华社这样的组织标记了真假。该算法检测了在新浪微博上关于这些故事的50000条微博,并以84%的正确率识别出了假新闻。曹的团队在2016年凤凰城AAAI会议上展示了这一成果。加州大学圣克鲁斯分校的de Alfarot和其同僚们在去年马其顿关于机械学习与数据库知识发现原理和时间的欧洲会议上也同样地公布,在Facebook上流传的假新闻可以根据哪些用户喜欢这些文章,来和真实新闻区分开来。

链接:

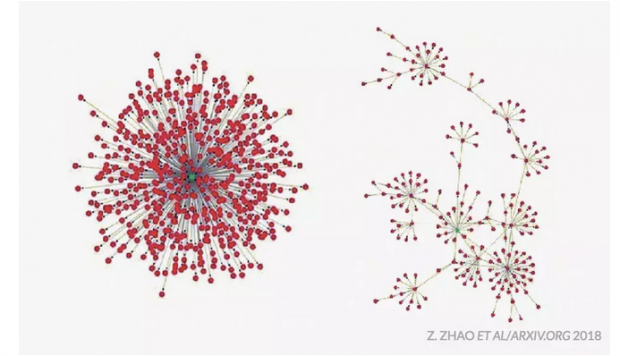

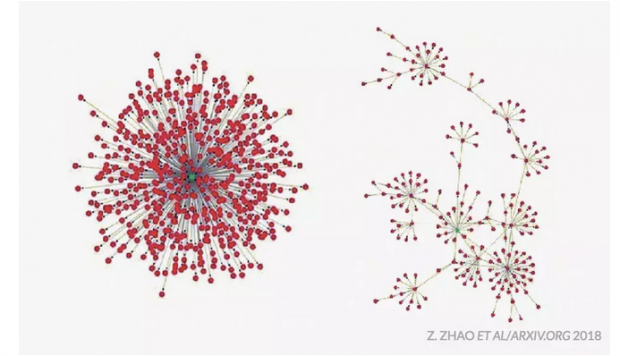

电脑会观察故事是怎样在社交媒体上传开的,而不是看哪些人和文章有互动。李和同僚们研究了社交媒体上的新闻故事转发的网络图形。研究人员分析了在微博上大约1700个虚假的和500个真实的新闻故事的转发网络图形,同样在Twitter上也分析了大约30个虚假的和30个真实的新闻网络。在两个社交媒体网站,李的团队发现,大多数人倾向于直接从一个来源转发真实新闻,然而假新闻倾向于更多通过人们转发其他转发者来传播的。

一种典型的真实新闻转发的网络“看起来更像一颗星星,但假新闻传播起来则像一棵树”李说到。即使李的团队忽略了信息是由像新闻频道本身的知名官方来源发布的,这一点依然成立。3月9日在上发表称,这些发现表明了电脑可以用社交媒体的参与度来作为真实性的检测,甚至不需要观察单独的帖子。

链接:

分叉传播

在推特上,大多数人转发(红点)真实新闻是从一个,集中的来源(绿点)。虚假新闻通过人们转发其他转发者来传播的。

真相

当假信息在社交网络上传播时,如何处理好它依然是一个待解决的问题。单单地把假文章从新闻推送里抹掉可能并不是办法。社交媒体平台用等级控制访问者什么看得到“就会像一个极权主义国家“,一个新加坡SSON分析的数据分析师墨菲·蔡(Murphy Choy)说到,“这会使所有相关的党派变得非常不舒服。“

平台可以在虚假信息上放警告标记。但是标记已经被证实是虚假的故事可能会带来一种不幸的“暗示真实的效果”。根据加拿大里贾纳大学(the University of Regina)和耶鲁大学(Yale University)的人类行为研究员戈登·彭尼库克(Gordon Pennycook)和大卫·兰德(David Rand )在去年9月的社会科学研究网络发表的研究称,人们可能会更加信任任何没有被明确标记为假的的故事,无论它们被没被检查过。

链接:

公司发言人斯文松(Svensson)说,Facebook没有删掉假故事,而是从用户的新闻推送下方揭穿假故事,这样可以减少一篇假文章未来80%的阅读量。此后只要用户遇到相关的假新闻,Facebook就会在下面展示辟谣文章,虽然这项技术有风险。

在研究喜欢并分享阴谋论新闻的Facebook用户时,佐罗(Zollo)和同事沃尔特·夸特罗奇奇(Walter Quattrociocchi)发现在阴谋家和揭发真相的文章互动之后,这些用户确实会在Facebook阴谋论的主页上提高活跃度。研究人员在社会系统中的复杂传播现象(Complex Spreading Phenomena in Social Systems)中发表了这一发现。

链接:

在教电脑和人类识别假新闻方面仍然有太多的工作要做。就像一句老话说:在真相穿上鞋之前,谎言能走半个世界了。但是锐利的电脑算法也许至少能用新的脚踝沙袋来减慢虚假新闻的传播。

参考文献:

K. Shu et al. “Fake news detection on social media: A data mining perspective.” . August 7, 2017.

B. Horne and S. Adali. This Just In: Fake News Packs a Lot in Title, Uses Simpler, Repetitive Content in Text Body, More Similar to Satire than Real News. International Conference on Web and Social Media, Montreal, Canada, May 15, 2017.

E. Tacchini et al. Some Like it Hoax: Automated Fake News Detection in Social Networks. ECML PKDD, Skopje, Macedonia, September 18, 2017.

F. Zollo and W. Quattrociocchi. Misinformation spreading on Facebook. Complex Spreading Phenomena in Social Systems. Published online June 22, 2018, p. 177. 10.1007/978-3-319-77332-2_10

G. Bastidas et al. Semi-supervised Content-based Detection of Misinformation via Tensor Embeddings. arXiv:1804.09088. Posted April 24, 2018.

G. Ciampaglia et al. Computational fact checking from knowledge networks. PLOS One. Published online June 17, 2015. doi: 10.1371/journal.pone.0128193.

G. Pennycook and D.G. Rand. The Implied Truth Effect: Attaching Warnings to a Subset of Fake News Stories Increases Perceived Accuracy of Stories Without Warnings. SSRN. Posted September 14, 2017. doi: 10.2139/ssrn.3035384.

S. Vosoughi, D. Roy and S. Aral. The spread of true and false news online. Science. Vol. 359, March 9, 2018, p. 1146. doi:10.1126/science.aap9559.

Z. Jin et al. News Verification by Exploiting Conflicting Social Viewpoints in Microblogs. Thirtieth AAAI Conference on Artificial Intelligence, Phoenix, Ariz., February 14, 2016.

Z. Zhao et al. Fake news propagate differently from real news even at early stages of spreading. arXiv:1803.03443. Posted March 9, 2018.

拓展阅读:

M. Temming. On Twitter, the lure of fake news is stronger than the truth. Science News. Vol. 193, March 31, 2018, p. 14.

M. Temming. Machines are getting schooled on fairness. Science News. Vol. 192, September 16, 2017, p. 26.

E. Engelhaupt. You’ve probably been tricked by fake news and don’t know it. Science News Online, December 4, 2016.

翻译:小邪

审校:张朔

编辑:孟婕

原文地址:

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号