本篇文章是翻译的Sebastian Ruder最近发布的一篇介绍,主要讲了他和Barbara Planck一起合作的发现,提出了一种在迁移学习中的数据选择指标。

1

介绍

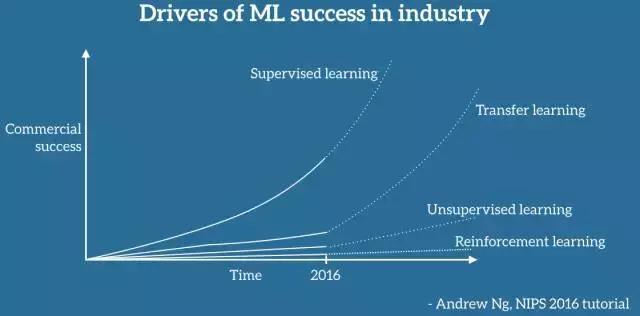

在机器学习中,通常假设我们模型使用的数据是相同的,即和训练数据是同分布的。但是一旦用于真实世界中,这种假设就会失效:我们应用的很多数据资源和原始的训练数据是截然不同的。所以在实践中,这会导致我们模型的性能非常糟糕。

域适应(domain adaptation)是一种典型的迁移学习,可以帮助降低训练数据和测试数据之间的差异。关于迁移学习的介绍可以看这篇博客 (见参考文献)。域适应的方法是用于一般化地寻求、识别两个域之间共享的特征或学习对于两个域有用的表示。在这篇博文中,我将会讨论我最近和Barbara Planck一起发表文章的动机与发现。在此,我们概述了域适应的一个补充方法,即我们会去学习选择对我们训练模型有用的数据而不是学习一个可以适应两个域之间的模型。

2

防止负迁移

对于迁移学习而言,选择数据的最主要的动机是为了防止负迁移,如果训练数据源的信息不仅没有用,反而会对目标域上的工作适得其反,便会产生负迁移。负迁移的典型例子是情绪分析:如果我们训练一个模型来预测图书评论的情绪分析,我们可以期待模型在书评这个域做的很好。然而,如果将这个模型迁移到电子产品的评论中,结果就是负迁移,我们模型学习到的术语与书籍情绪有关,而对于电子产品的评论则意义不大。

在从一个源到一个目标域的适应性的经典场景中, 我们唯一可以做的是创建一个能够解开这些从意义上转变的模型。然而,在两个非常不同的域之间进行适应仍然会频繁地失败或者模型表现非常差劲。

在现实世界中,我们通常可以访问多个数据源。在这种情况下,我们可以做的一件事是对我们的目标域最有帮助的数据进行训练。 然而,我们尚不清楚如何确定源数据对目标域的有用性的最佳方法。 现有工作通常依赖于源和目标域之间的相似度度量。在这种情况下,一件我们可以做的事情就是对我们的目标域最有帮助的数据进行训练。然而,确定源数据对目标域的有用性的最佳方法是雾里看花。 现有工作通常依赖于源和目标域之间的相似性度量。

3

数据选择的贝叶斯优化

我们的假设是,选择迁移学习训练数据的最佳方式取决于任务和目标域。 此外,虽然现有的指标只考虑与目标域有关的数据,但我们也认为,一些训练实例本身比其他训练实例更有帮助。

由于这些原因,我们建议学习迁移学习的数据选择指标。 我们使用贝叶斯优化(Bayesian Optimization)来实现,该框架已成功地用于优化神经网络中的超参数,并可用于优化任何黑盒功能。 我们通过定义与训练数据与目标域的相似性以及其多样性相关的几个特征来学习此功能。 在多次迭代过程中,数据选择模型就能够学习相关任务中特征的重要性。

4

评估和结论

我们评估我们的方法在情绪分析,部分词性标签和依赖关系解析这三个任务上的表现,并比较了随机选择方法、选择最相似的源域或最相似的训练示例的现有方法。

对于评论的情绪分析,在最相似域进行训练是一个很强的基准线,因为评论类别具有明确的界定。我们的模型显著地提高了这一基准线,并且论证了多样性和相似性是互补的。我们甚至和最先进领域的适应方法进行了性能比较,尽管没有表现出任何的适应性。

对于部分词性标签和依赖性解析,我们观测到了更小但更一致的提升。最后,我们评估学习方法在模型、任务和领域中的迁移能力。我们发现,一个数据选择指标可以用更简单的模型来学习,该模型也被用作最先进的模型的替代。正如人们所想的那样,在如POS标记和解析的相关性任务中,在域和任务中的迁移是具有鲁棒性的,但是在如解析和情感分析的不相关任务中却会失败。

在本文中,我们展示了选择相关数据对迁移学习的重要性。我们表明,在考虑到任务和特定域的特征之后,学习出的一个合适的数据选择指标要优于现有的指标。我们发现,在选择恰当的训练数据时是多样性和相似性互补,并且学习到的指标可以在模型,领域和任务中鲁棒的进行迁移。这项工作将在2017年自然语言处理实践方法大会上发表。更多的细节可以在这里的论文中找到。

5

参考文献

1.关于迁移学习的综述,可以看Sebastian Ruder写得一篇博客介绍:

2.关于上面说到的迁移学习选择数据的方法可以看Sebastian Ruder和Barbara Planck合作的论文:Learning to select data for transfer learning with Bayesian

3.2017年自然语言处理实践方法大会:

推荐阅读

AI改变了科学——《科学》最新AI特刊|前沿

人工智能社会学—未来的新兴学科?——AI视野(四)|张江

集智QQ群|292641157

商务合作|

投稿转载|

◆ ◆ ◆

搜索公众号:集智俱乐部

加入“没有围墙的研究所”

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号