导语:金融机构已经开始用深度学习算法来识别欺行为了,那有没有可能通过某些手段,欺骗深度学习算法呢?来自乔治亚理工大学、蚂蚁金服和清华大学的研究人员发现了机器学习模型的新风险:通过制造具有欺骗性的数据结构,可以误导机器学习模型做出错误预测。

编译:集智翻译组

来源:

原题:CSE Researchers Assess Adversarial Attacks on Networks

深度学习模型,一种机器学习(ML)的形式,已被用于多种日常任务的决策过程中,如欺诈识别、心脏衰竭的早期征兆诊断

然而,由于深度学习模型本质上的预测性,其很容易遭受到攻击。攻击者可以轻易通过对图结构(也被称为网络)中的数据结构进行组合来欺骗模型。

来自研究深度学习模型如何克服易被黑客攻击

论文题目:对图结构数据的对抗攻击

Adversarial Attack on Graph Structured Data

论文地址:

Scarselli et al., 2009Dai et al., 2016Kipf & Welling, 2016Hamilton et al., 2017

所有对抗问题的前提是:首先通过攻击了解一个模型可被如何攻击,其次修正在此过程中发现的缺陷以加强系统。

“本文研究的是一个对抗问题:在图上给出一个有效的深度学习方法后,我们能否以一种不可避免的方式修改网络,从而使得深度学习方法在此种情况下失效?”乔治亚理工大学计算机科学与工程学院的博士生Hanjun Dai如是说到。

任何潜在攻击的需求是至关重要的,因为其应用普遍且广泛。

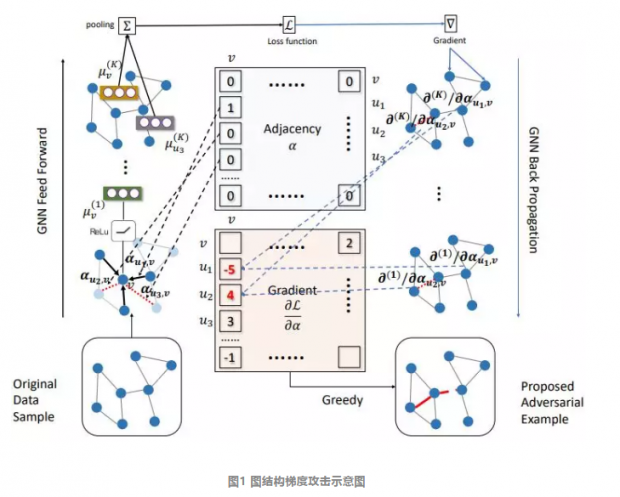

“我们展现出的是,通过对交易网络的一小部分进行改变,就可以改变机器的行为,”乔治亚理工大学计算机科学与工程学院副教授、机器学习中心副主任Le Song说到,“例如,就金融应用而言,我可以将钱转到其他地方,就可以改变机器学习模型使其做出错误的预测。”图1为一种图结构梯度攻击。

这一白盒攻击可通过最大化梯度幅值来增加或删除边。

深度学习模型尤其容易受到此类攻击操纵的影响——通过各种领域和方法来解决这一问题,如图1所示

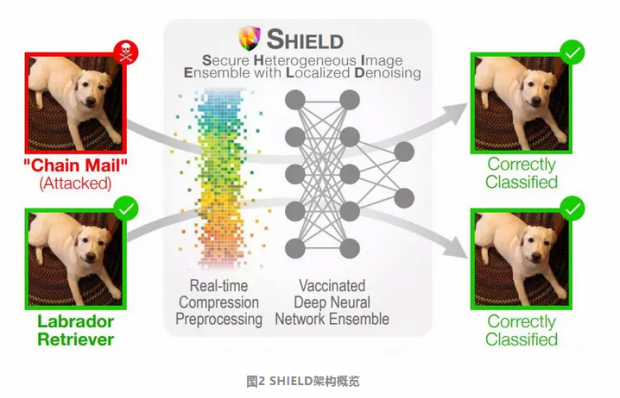

SHIELD对抗攻击图片(红色图片)的方法是使用随机局部量化(SLQ)实时消除扰动,以及使用针对对抗性和良性图片均有鲁棒性压缩变换的接种模型集合。

该方法消除了最近出现的94%的黑盒攻击以及98%的灰盒攻击,例如Carlini-Wagner的L2以及DeepFool。Das, N., Shanbhogue, M., Chen, S. T., Hohman, F., Li, S., & Chen, L., et al. (2018). Shield: fast, practical defense and vaccination for deep learning using jpeg compression.

Dai说到,“这一研究与深度学习方法的鲁棒性和可靠性高度相关,我们是首个在组合结构(如网络)上研究这一问题的团队。”

“我认为网络表达了丰富的关于世界的组合知识信息,”Dai说到,“例如,社交网络表达了有关用户关系的知识;知识网络描述了实体间的逻辑概念。另一方面,深度学习以一种连续但不透明的方式学习知识。如何将清晰的硬性规则和深度学习的黑盒结合起来是这个研究方向的未来。”

在ICML2018会议上,Dai和Song将会对这篇论文以及其团队的另外5篇论文进行展示。

学习解释:关于模型解释的信息理论视角

Learning to Explain: An Information-Theoretic Perspective on Model Interpretation

Jianbo Chen (University of California, Berkeley) · Le Song (Georgia Institute of Technology) · Martin Wainwright (University of California at Berkeley) · Michael Jordan (UC Berkeley)

论文链接:

对图结构数据的对抗攻击

Adversarial Attack on Graph Structured Data

Hanjun Dai (Georgia Tech) · Hui Li (Ant Financial Services Group) · Tian Tian () · Xin Huang (Ant Financial) · Lin Wang () · Jun Zhu (Tsinghua University) · Le Song (Georgia Institute of Technology)

论文链接:

针对黑盒迭代机器教学

Towards Black-box Iterative Machine Teaching

Weiyang Liu (Georgia Tech) · Bo Dai (Georgia Institute of Technology) · Xingguo Li (University of Minnesota) · Zhen Liu (Georgia Tech) · James Rehg (Georgia Tech) · Le Song (Georgia Institute of Technology)

论文链接:

在图中学习迭代算法的稳定状态

Learning Steady-States of Iterative Algorithms over Graphs

Hanjun Dai (Georgia Tech) · Zornitsa Kozareva (Amazon) · Bo Dai (Georgia Institute of Technology) · Alex Smola (Amazon) · Le Song (Georgia Institute of Technology)

论文链接:

图卷积神经网络的随机训练

Stochastic Training of Graph Convolutional Networks

Jianfei Chen (Tsinghua University) · Jun Zhu (Tsinghua University) · Le Song (Georgia Institute of Technology)

论文链接:

SBEED: 用非线性函数逼近的收敛强化学习

SBEED: Convergent Reinforcement Learning with Nonlinear Function Approximation

Bo Dai (Georgia Institute of Technology) · Albert Shaw (Georgia Tech) · Lihong Li (Google Inc.) · Lin Xiao (Microsoft Research) · Niao He (UIUC) · Zhen Liu (Georgia Tech) · Jianshu Chen (Microsoft Research) · Le Song (Georgia Institute of Technology)

论文链接:

翻译:非线性

审校:奔跑的笤帚把子

编辑:孟婕

原文地址:

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号