导语

近日,研究者在Nature Communications上发表了一项研究, 通过分析十个月内Twitter上400000篇文章传播情况,发现社交网络机器人在低质量内容传播中有着重要作用,为了达到文章病毒式传播效果,它们会事先寻找特定用户,而这些用户对这种定向打击毫无抵抗力。

论文原题:

The spread of low-credibility content by social bots

论文地址:

当今社会,网络错误信息的广泛传播会对社会民主造成很大威胁。当我们使用社交媒体时,我们就会碰到各种各样虚假或是误导性报道,比如骗局、阴谋论、标题党或是伪科学。

这些错误信息的病毒式传播成因复杂,来自各个领域的科学家正联合社交媒体平台进行研究,并以期采取相应的措施。

曝光:低质量内容产出者大起底

假新闻更“有毒”

研究者不考虑那些已经被揭露真相的特例故事,而是追踪低质量内容的来源。这些来源被权威第三方媒体机构和事实核查组织认定为“长久产出低质量内容者”,以此表明这些低质量内容产出机构不遵循新闻诚信。

研究者通过爬虫追踪120处低质量内容来源,发现大多数低质量内容都是错误信息。 他们还通过爬虫收集了七个事实核查机构产出的文章。在2016年中到2017年3月底期间,一共收集到了低质量来源389569篇文章和事实核查机构的15053篇文章,并进一步收集了与低质量文章相关的13617425条Twitter以及事实核查过的文章相关的1133674条Twitter。

低质量媒体平均每周产出100篇文章。然而同时,低质量内容的流行度分布与那些真实的新闻流传度分布几乎一样,低质量内容也可能流传甚广。这与以前一项分析不谋而合:假新闻比真新闻更可能呈病毒式传播。

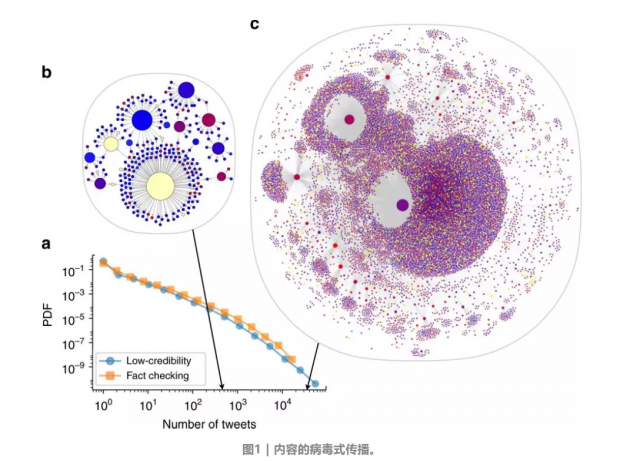

点表示的是Twitter账号,连线表示的是文章转发。点的大小代表账号影响力,衡量的标准是一段时间内账号的被转发数。点的颜色展示机器人指数,从蓝色(可能是真人)到红色(可能是账号机器人),黄色的点难以判断,因为这些账号要么被关停了,要么删除了所有Twitter内容。

a Twitter上低质量来源文章(蓝圈)的概率分布,和经事实核查的文章(黄色正方形)的概率分布。两种文章分享的的账户数分布类似。

b 一篇题为《FBI刚刚颁布了Anthony Weiner的逮捕令证明他们操控了大选》的中度病毒传播的文章在2016年大选后在400条Twitter中转发。

c 一篇名为《精神烹调》的重度病毒性传播的文章,讲的是2016年大选4天前,Clinton的竞选委员会主席进行了一场神秘的仪式,这篇文章在30000条Twitter中被传播。

这里我们需要注意的是所有转发都指向原文,多个层级的转发都包含了同一篇文章的链接。如果要看到这个传播网络的交互,请移步:

特征:慧眼识别低质信息

科学家们还发现了一些低质量文章传播的独有特征。

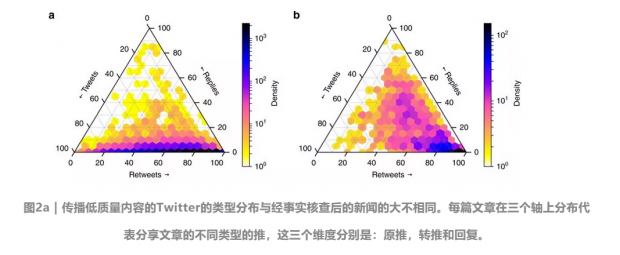

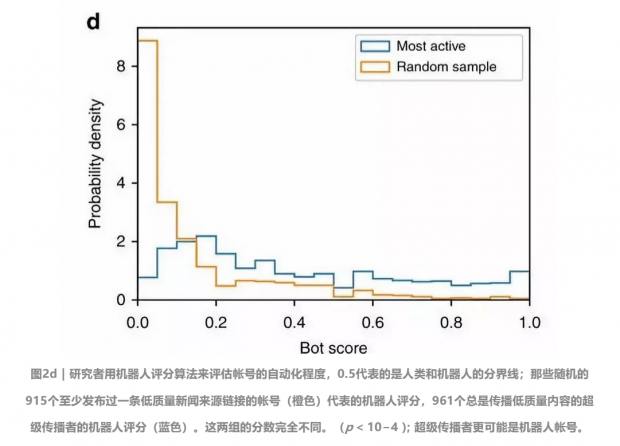

第一个特征是大多数低质量文章通过原推和转推传播,很少有在回复中传播的(图2a),而事实核查过的文章则是转推和回复都会被分享(图2b)。

当用户Alice转了用户Bob的推,这个推就被转发给所有Alice的粉丝看,而当Alice回复Bob的推时,这个回复只会被Bob和Bob和Alice的共同粉丝看到,颜色代表的是每篇文章在各自容器内的数量。

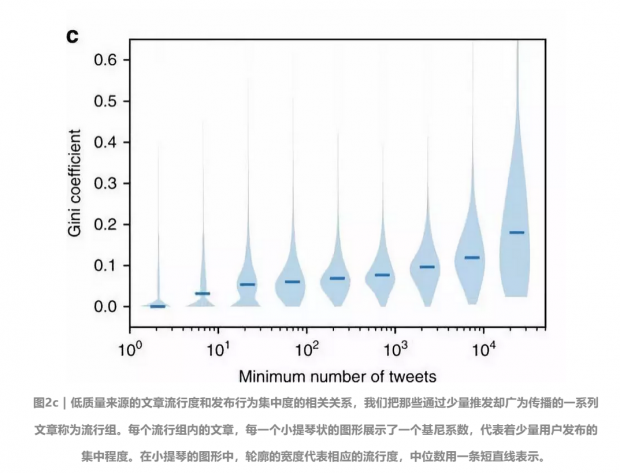

第二个特征是这些转发量很大的推文会更多集中在少数大号,这些大号被称为“超级传播者”(图2c)。这个发现是反直觉的,一般我们都以为一篇文章传播的越广,看到的人越多,那么特定的群体或账号重要性越低。

套路:社交机器人的传播策略

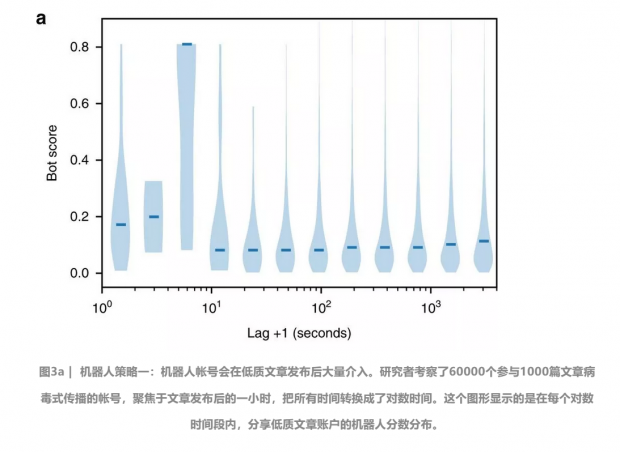

既然机器人账号在传播低质内容中很重要,那么它们是否在传播的某些阶段非常关键呢?

研究者通过研究发现,类机器人账号在低质文章发布后的几秒内极其活跃,比之后的时间段都要活跃(图3a)。以此猜想,这种机器人账号的早期介入会明显增大低质文章变成病毒式传播的机会。

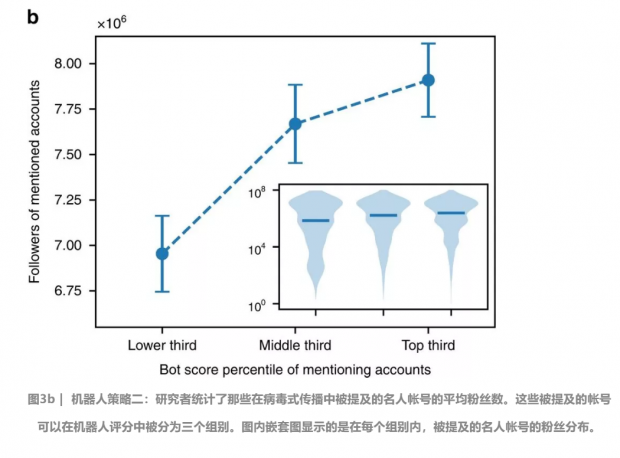

除了早期介入外,另一个策略是提及名人。

比如@realDonaldTrump这个账号就在19条推里面被提及,每条推都与非法移民的投票的假新闻有关。账户的粉丝数基本上可以衡量这个账户在Twitter上的影响力,机器人账号通过不断提及这些名人账号,提升爆光度,要是这些账号中能有一两个转发,那么这个低质内容很有可能变成病毒式传播。

警惕:机器人和僵尸粉的力量

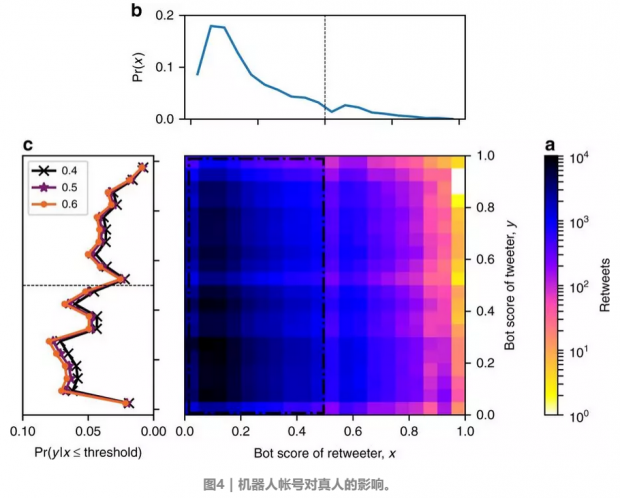

我们已经发现了这些机器人和僵尸粉的行为特征,再来看看在低质内容的传播上,真人如何参与交互。

图4a显示真人账户转发推送情况。研究者发现人们无法区分真人账户转发的低质内容和机器人账户转发的低质内容,甚至从推送量来看,真人转发与机器人转发呈类线性关系,也就是说,他们转发机器人账户的推送数目跟转发真人账户推送数目相差无几。这在一定程度上表示,社交机器人的存在会加速低质内容在真人社交网络的传播。

简单地说,就是每次机器人的转发都会有一定程度的真人的参与,使得低质信息传达到更多的真人账户 。而类似的加速现象在经事实核查后的新闻中却不存在。

a表示的是传播低质内容的机器人评分分布和首次传播低质内容账户的机器人评分分布。

b上部显示的是转发的人的机器人评分分布,这些账户主要是真人。

c左部显示的是转发真人账户的机器人评分分布,对应的分别是评分0.4以下(黑叉),0.5以下(紫星)或0.6以下(橙圈)。不管是那个阈值下,研究者都发现有很大一部分的推送是真人账户转发机器人账户。

角色定位:擒贼先擒王

要理解机器人账号的力量,还需要评估他们在传播网络中的角色。

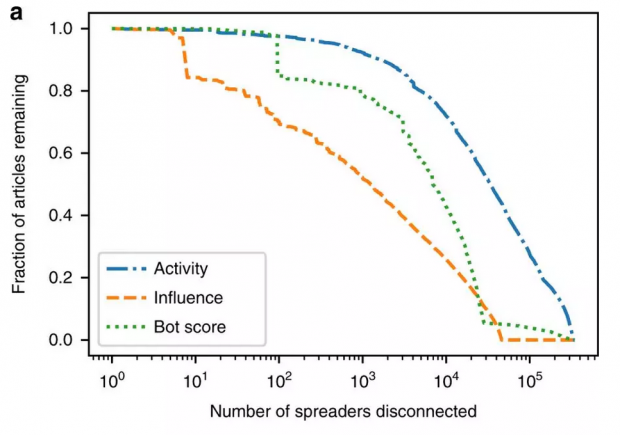

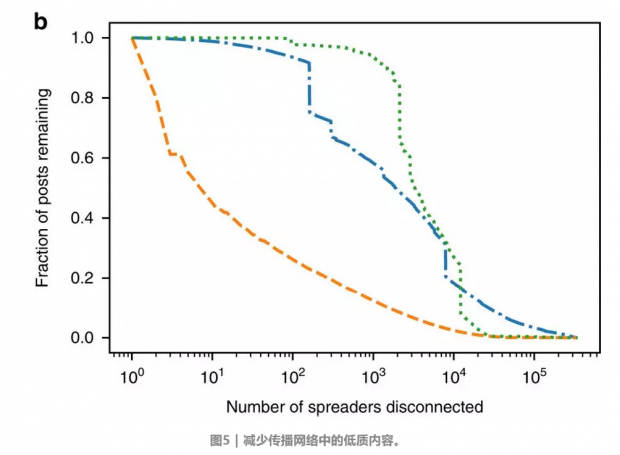

聚焦转发网络,这个网络里点代表账户,连结代表转发,研究者采用了一种网络拆除技术,每一次取消一个用户的连结,然后分析转发数的减少和文章数目的减少。这时候减少数目越多,那就代表这个节点在整个网络中更重要。

这个分析基于低质内容的转发网络,数据来自于 2016年美国大选。这个网络中有227363个节点(账户);隔离账户基于几个标准:影响力,活跃度和机器人评分。

研究者根据机器人评分,转发数和账号影响力来优先隔离某些账号。图5显示的是那些有影响力的账户在网络中非常重要,它们都并不是机器人账号。因此,我们可以推断,隔离那些机器人评分高的账户可以有效降低低质内容的传播。

这个策略在隔离10%账号时表现不错(图5b)当然,这些策略仍然没有直接在源头减少低质内容的生产那样有效。

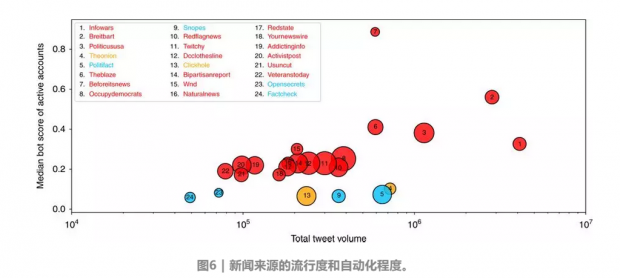

传播度:衡量破坏力

最后,研究者比较了机器人账号传播低质内容的程度。根据传播的中位数,总数和机器人评分,来衡量传播的程度。图6显示,一个网站,它有很大的自动化程度,其他低质内容来源也有很多社交网络机器人。而那些讽刺性的账号内容比如洋葱新闻社和事实核查过的网站往往没有这种程度的自动化。

提供讽刺性内容的网站是橙色,经过事实核查的网站是蓝色,而低质内容来源是红色。采用推送的总数(横轴)和每篇文章的中位数(圆圈区域)来衡量流行度,用100个最活跃账号的机器人评分的中位数来衡量自动化程度(纵轴),低质内容的来源有更高的自动化程度,从中位数和总数上来看都是这样。

总结:值得讨论的防范措施

此研究主要有几大发现:

(一)机器人账号在低质内容广为传播前就已介入;

(二)机器人账号通过回复和瞄准大号的方式操纵传播;

(三)人们对于这样的操纵毫无抵抗力。

这篇文章的发现表明社交媒体机器人是一种很有效的操纵社交网络导向的方式。我们今天聚焦的是低质量内容,比如假新闻,阴谋论和伪科学。但我们也要警惕类似的策略被用于传播有害的内容,比如说病毒软件。我们也要警惕这种策略在不同的社交媒体平台上被有不良居心的人使用。

那么如何有效阻止呢?

第一个方法,抑制社交网络机器人的使用。要想实施这一措施,需要社交网路媒体平台与科学家的合作与部署相应措施。

第二个办法,使用验证码,验证码的各种形式可以检测用户是否为真人。这种技术已经应用于垃圾邮件检测和和其他滥用网络的行为。但是这会导致所有媒体的自动化程度的降低,比如有些严谨的新闻媒体和危机回应机构。

未来希望有研究能进一步研究出更具体可行的措施防止机器人账号的滥用,也希望有研究能把本研究的成果拓展到更多的社交网络平台,拓展到其他国家的社交网络平台,为这一研究提供更大的视角和更深的理解。

作者:Frank Xu

编辑:王怡蔺

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号